Utilizar la inteligencia artificial en las comunicaciones empresariales ya no es una opción, sino un reflejo. Pero hay que hacerlo sin arriesgar la credibilidad, el cumplimiento de las normas... o la reputación. Entre la entrada en vigor de la Ley de IA, las normas impuestas por las plataformas y los abusos ya observados, ¿cómo utilizar la IA de forma profesional, responsable y transparente? Frédéric Foschiani, experto en medios sociales e IA para la comunicación, explica las precauciones que hay que tomar para sacar partido de la IA sin perder el control de su comunicación.

Redactar un post en cuestión de segundos, generar un visual original, analizar las tendencias del sector... La inteligencia artificial se ha convertido en el asistente favorito de los comunicadores. Pero tras la promesa de eficacia se esconde una realidad más compleja: la responsabilidad. Cada contenido generado, cada dato utilizado o cada imagen modificada conlleva ahora una obligación de transparencia y nos expone a riesgos legales y de confidencialidad.

La entrada en vigor del reglamento europeo sobre IA, el’Ley AI, y las nuevas reglas impuestas por las plataformas están cambiando profundamente las prácticas. Así que la cuestión ya no es ¿debe utilizarse la IA? Pero ¿cómo puede utilizarse de forma profesional y responsable? Entre el cumplimiento, la transparencia y la credibilidad, lo que está en juego es evidente. Se trata de hacer de la IA una palanca de la calidad, no un factor de confusión.

Entender el nuevo marco: la Ley de IA y su impacto

La Ley de IA en la práctica

Con entrada en vigor el 1ᵉʳ de agosto de 2024, el Acta Europea de la IA es la primera normativa global, transversal y jurídicamente vinculante dedicada exclusivamente a la IA. ¿Su principio? Clasificar los sistemas de IA según cuatro niveles de riesgo (inaceptable, alto, limitado y mínimo), con obligaciones graduadas, sobre todo en términos de transparencia para determinados usos. Algunas de estas disposiciones ya están en vigor desde febrero de 2025. Entre ellas, la prohibición de los sistemas de IA que presenten riesgos inaceptables y la exigencia de una «cultura de la IA» (Alfabetización en IA) prevista en el artículo 4 de la Ley AI.

Ejemplos de riesgos inaceptables

Manipulación cognitiva y conductual de las personas

Sistemas de IA que :

- explotar defectos psicológicos o cognitivos

- manipular el comportamiento sin que la persona sea consciente de ello

- puede causar daños físicos o psicológicos

👉 Ejemplo: una IA que empuja sutilmente a un individuo vulnerable (niño, persona frágil) a adoptar un comportamiento peligroso o autodestructivo.

Explotación de personas vulnerables

Prohibición de la IA dirigida específicamente :

- niños

- personas con discapacidad

- personas social o económicamente vulnerables, con el fin de influir en sus decisiones o comportamientos

👉 Ejemplo: un juguete inteligente que utiliza IA para animar a un niño a comprar un producto o adoptar un comportamiento específico.

Puntuación social a la china

Sistemas que :

- evaluar o calificar a las personas en función de su comportamiento

- cruzar datos sociales, personales y de comportamiento

- dar lugar a sanciones, exclusión o discriminación

👉 Ejemplo: asignar una «calificación ciudadana» que influya en el acceso a la vivienda, a un empleo o a un servicio público.

Identificación biométrica a distancia en tiempo real (con excepciones muy limitadas)

Prohibición general del reconocimiento facial en tiempo real en espacios públicos con fines de vigilancia masiva.

⚠️ Existen excepciones muy limitadas para los funcionarios encargados de hacer cumplir la ley (terrorismo, personas desaparecidas, etc.), sujetas a un estricto control judicial.

👉 Ejemplo de prohibición: escanear automáticamente rostros en una calle o estación para identificar a personas sin ninguna base jurídica específica.

ElAlfabetización en IA concierne a todos aquellos que utilizan la IA en un contexto profesional: comunicación, marketing, RRHH, jurídico, finanzas, etc. No se limita a las redes sociales. No se trata de una certificación técnica, sino de una obligación de medios. Las organizaciones deben asegurarse de que sus equipos comprenden las capacidades, los límites y los riesgos de la IA, así como las buenas prácticas, sobre todo en lo que respecta a la fiabilidad de los contenidos, la parcialidad y el impacto en la reputación.

Los requisitos específicos para los modelos de IA de propósito general se aplican desde agosto de 2025. La mayoría de los requisitos, sobre todo en materia de transparencia, entrarán plenamente en vigor. 2 de agosto de 2026. A continuación, se introducen progresivamente determinados requisitos hasta 2027.

Para los comunicadores, este texto es interesante. Pone de relieve un riesgo vinculado a la transparencia en la creación de contenidos y la comunicación en línea. Puntos clave: la Ley de AI impone un marco de gobernanza reforzado, que incluye obligaciones de transparencia, trazabilidad y rendición de cuentas.

Falta de transparencia: un riesgo jurídico y para la reputación

Los artículos 50 y 99 de la Ley de AI establecen dos principios fundamentales.

👉 Informar al público . Cuando el contenido ha sido generado o modificado por una IA, especialmente en el caso de imágenes realistas, deepfakes o voces sintetizadas.

👉 Sancionar las infracciones. Hasta 35 millones de euros o 7 % del volumen de negocios mundial para determinados delitos (por ejemplo, prácticas prohibidas) y hasta 15 millones de euros o 3 % del volumen de negocios para otros, incluidas las obligaciones de transparencia.

En la práctica, publicar un visual generado o modificado por IA sin mencionarlo puede desencadenar un riesgo de incumplimiento (Ley de IA y normas de la plataforma), especialmente si el contenido es realista y puede inducir a error.

Para las empresas, esto significa una nueva responsabilidad editorial. Deben ser capaces de demostrar el origen de los contenidos y asumir su naturaleza.

Estas obligaciones de transparencia serán plenamente aplicables a partir del 2 de agosto de 2026. Hasta entonces, las empresas deberán anticiparse a estos requisitos mediante sus propios sistemas de información y etiquetado.

El etiquetado consiste en informar al público de que el contenido ha sido generado o modificado por una IA, cuando esta información es necesaria para evitar cualquier confusión con el contenido auténtico. Es una herramienta para la gobernanza editorial y el cumplimiento de la normativa.

RGPD, CNIL y coherencia ética

La CNIL, En sus recomendaciones 2025, la Autoridad Europea de Supervisión de Protección de Datos (SEPD) reitera la importancia de informar a las personas y permitirles ejercer sus derechos de manera efectiva en el contexto de los modelos de IA, en consonancia con el RGPD.

Hay más en juego que el mero aspecto jurídico: afecta a la confianza digital.

Una comunicación producida o asistida por IA debe cumplir los mismos requisitos que cualquier otro dato. Estos requisitos se refieren a la veracidad, el respeto del consentimiento y la ausencia de manipulación. Aquí es donde radica la diferencia entre un uso responsable y uno descuidado.

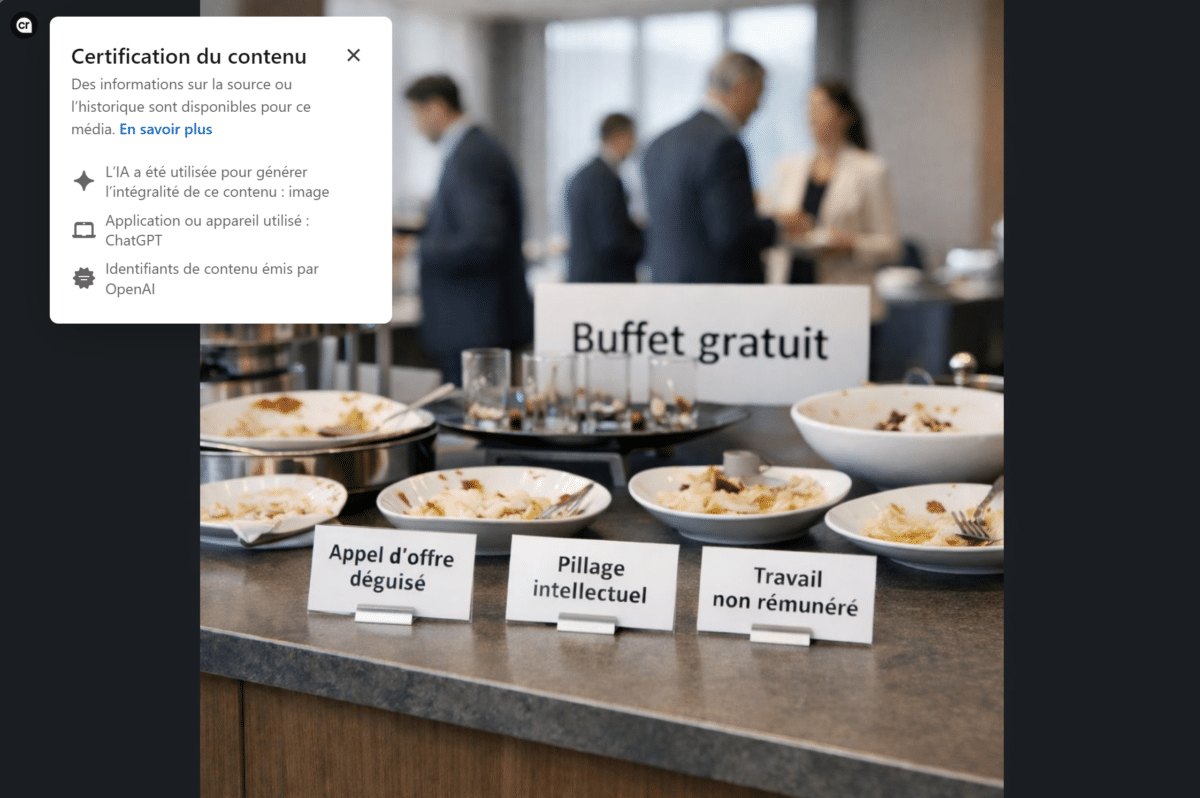

Las plataformas pasan a la acción: transparencia y control

LinkedIn: uso de credenciales de contenido para hacer visible el origen de los contenidos

LinkedIn se basa en la C2PA (Coalición para Procedencia y autenticidad de los contenidos). Esta norma fue creada por un consorcio de empresas tecnológicas y de medios de comunicación (Adobe, BBC, Microsoft, Intel, etc.). Muestra información sobre la procedencia en los metadatos de los archivos multimedia.

Estas «credenciales de contenido» indican si una imagen ha sido generada o modificada por IA. En algunos casos, pueden utilizarse para rastrear el historial de edición (nombre del autor, plataforma de IA utilizada). Cada imagen o vídeo generado por IA puede ahora etiquetarse automáticamente, indicando su origen o modificación.

Esta iniciativa marca un cambio fundamental. Las redes sociales profesionales se están convirtiendo en garantes de la fiabilidad de las publicaciones, tal como exige la Ley de AI. Esta información no siempre es visible por defecto. Sin embargo, envía una señal fuerte en términos de transparencia y responsabilidad editorial en una red profesional.

Para los comunicadores, esto refuerza la necesidad de controlar la trazabilidad de los elementos visuales y evitar cualquier ambigüedad sobre la naturaleza del contenido publicado.

Meta y YouTube: el etiquetado se convierte en norma

Meta (Facebook, Instagram, Threads) ha anunciado el etiquetado automático de imágenes creadas por IA mediante metadatos incrustados (C2PA e IPTC).

Estas medidas de transparencia tienen por objeto informar a los usuarios sobre el origen de los contenidos. También pretenden generar confianza, en consonancia con los nuevos requisitos normativos y las políticas de las redes sociales.

Meta también cambió la terminología de sus etiquetas en 2024 para distinguir más claramente entre los contenidos «creados con ayuda de IA» y los «alterados significativamente». El objetivo declarado es que la etiqueta sea más fácil de leer para los usuarios, al tiempo que se basa en señales de procedencia en lugar de una simple declaración manual.

YouTube, por su parte, exige ahora la divulgación de contenidos significativamente modificados o generados por IA cuando parezcan realistas, en particular si representan personas, acontecimientos o situaciones creíbles.

Esta obligación se refiere explícitamente al uso profesional y está destinada a limitar los riesgos de engaño o desinformación.

El objetivo de estas prácticas no es restringir la creatividad, sino mantener la confianza. La transparencia se está convirtiendo en una nueva norma de comunicación. Es mejor mostrar el origen del contenido que dejarlo en entredicho.

TikTok: autodeclaración y detección automática

TikTok también ha adoptado la norma C2PA y ha introducido el etiquetado automático (auto-flag) Vídeos IA importados de otras plataformas. Los contenidos generados por sus propias herramientas se etiquetan automáticamente. Este filtrado está pensado para combatir la información falsa, pero también para proteger las marcas. Porque en una red en la que la autenticidad percibida es el valor de un mensaje, un error de etiquetado o un visual demasiado artificial pueden minar rápidamente la credibilidad.

Cómo identificar los contenidos generados por IA

Normas de origen como C2PA o metadatos IPTC desempeñan un papel fundamental en la identificación de los contenidos generados por la IA. Permiten integrar información sobre el origen de un archivo, las herramientas utilizadas o las modificaciones realizadas. Sin embargo, estos dispositivos no son infalibles. Los metadatos pueden borrarse durante la reexportación, y no todas las herramientas los implementan de la misma manera.

En otras palabras, los metadatos IPTC/C2PA ayudan a identificar el origen de los contenidos. Pero nunca podrán sustituir a la gobernanza editorial ni a los sistemas internos de información.

*IPTC (Consejo Internacional de Telecomunicaciones de Prensa) es un organismo internacional que define las normas sobre metadatos utilizadas por los medios de comunicación, las agencias de prensa y las plataformas digitales, integrando directamente en los archivos (imágenes, vídeos, documentos) información como autor, fecha y lugar de creación, derechos de uso y, más recientemente, indicaciones vinculadas a contenidos generados o modificados por inteligencia artificial.

Integre la IA en su estrategia sin arriesgar su reputación y confidencialidad

La IA como aliada: optimizar sin quitar responsabilidad

Más allá de la creación de visuales y vídeos, la IA puede ser una herramienta formidable para la vigilancia sectorial, allá escribir posts o el generación de ideas creativas. Pero no piensa, ni comprueba, ni entiende el contexto.

Antes de cualquier publicación, deben sistematizarse cuatro reflejos:

- Nunca introducir datos personales o información confidencial (clientes, RRHH, contratos, datos financieros, estrategia, etc.) en una herramienta de IA que no haya sido validada por la empresa, incluso con fines de reformulación.

- Exigir a AI que cite sus fuentes (artículos, estudios, cifras)

- Comprobación y verificación de datos proporcionado por AI

- Adaptar el tono y el mensaje posicionamiento de la empresa

Una IA puede sugerir una tendencia viral... pero sólo un comunicador sabe si realmente sirve a la estrategia.

Voz experta - Frédéric Foschiani

«Utilizo regularmente la IA como ayuda para el seguimiento y la ideación editorial. Pero hay una regla que nunca cambia: no se deben utilizar datos, cifras ni citas sin verificación humana. La IA puede sugerir ángulos o tendencias, pero con demasiada frecuencia produce contenidos creíbles... pero falsos. El ejemplo de Deloitte ilustra perfectamente este riesgo. En un contexto profesional, publicar información errónea comprometerá la responsabilidad y la credibilidad de su autor y de su empresa».»

Formalizar una carta interna del usuario

La aplicación de una carta interna de AI es actualmente una buena práctica, tal como recomienda el artículo 4 de la Ley de AI (alfabetización en AI).

En particular, debe especificar el :

- herramientas autorizadas

- usos aceptables

- normas de confidencialidad aplicables al uso de herramientas de IA

- normas de trazabilidad y etiquetado de los contenidos generados o modificados por IA

- menciones que se mostrarán cuando una IA genere o modifique contenidos

- necesidad de una revisión humana sistemática

Algunas empresas ya han formalizado este marco, llegando incluso a incluir un «procedimiento de divulgación IA» para sus publicaciones, especialmente en las redes sociales.

Este sistema interno pretende informar al público o a los usuarios cuando un contenido ha sido generado o modificado por inteligencia artificial, para evitar cualquier confusión con la producción humana o la información auténtica. Este tipo de iniciativa demuestra un enfoque maduro: la tecnología se integra en las prácticas, pero nunca se utiliza sin control.

Voz experta - Frédéric Foschiani

«Esta necesidad de un marco no es teórica. Surge de forma muy concreta sobre el terreno. Cuando presto apoyo, compruebo que el error más frecuente no es el uso de la IA, sino la ausencia de un marco. Cada vez más empresas ponen a disposición soluciones internas de IA para limitar los riesgos asociados a la difusión de datos sensibles o confidenciales fuera de la organización. Sin embargo, estas herramientas se despliegan a menudo sin un verdadero apoyo a los equipos en términos de buenas prácticas. Los empleados disponen de la tecnología, pero no siempre de la orientación que necesitan para utilizarla de forma eficaz y responsable. Esto se aplica tanto al dominio del prompting -saber formular una petición clara para obtener un resultado que pueda utilizarse rápidamente- como a la comprensión de los límites de la IA, sus sesgos o las obligaciones reglamentarias que deben respetarse en un contexto profesional, en particular en materia de transparencia y trazabilidad de los contenidos. Sin este marco, la IA se convierte en una herramienta infrautilizada o, por el contrario, en un factor de riesgo evitable para la comunicación y la reputación de una empresa».»

Anticipar los errores y las crisis de comunicación

La historia reciente está llena de ejemplos en los que la IA ha traicionado la comunicación a la que estaba destinada. Por ejemplo, una empresa publicó una imagen generada por IA de un equipo médico para ilustrar una campaña. Los internautas detectaron rápidamente la artificialidad de la imagen: errores anatómicos, caras borrosas y detalles incoherentes. Como resultado, la empresa fue acusada de tergiversar y explotar a seres humanos. Incluso fuera de las redes sociales, este tipo de errores recuerdan la necesidad de estar alerta.

Octubre de 2025, Deloitte se ha visto obligada a reembolsar al gobierno australiano tras presentar un informe plagado de errores generados por IA. Se encontraron referencias falsas, citas jurídicas inexactas e incoherencias, atribuidas al uso incontrolado de herramientas generativas de IA. Este ejemplo ilustra un punto clave: un error generado por la IA siempre se convierte en un error humano.

Acciones previstas :

- formación en el uso adecuado de la IA para comprender los sesgos y los riesgos

- dominar las indicaciones para ser lo más preciso posible en las instrucciones dadas a la IA

- instituir un estricto protocolo de validación (corrección de pruebas, comprobación de fuentes, pruebas de coherencia)

- establecer un plan de respuesta a crisis, incluyendo mensajes aclaratorios, rectificaciones públicas y transparencia sobre el origen del error

- conservar y archivar un registro de contenidos generados por IA garantizar la trazabilidad

Un error de IA, ya sea interno o externo, en un sitio web o en un post, tarde o temprano siempre se convierte en un error, un error de comunicación. Los procesos de control y reacción no son una opción: son la red de seguridad de cualquier estrategia responsable de IA.

Credibilidad, calidad y SEO: los nuevos indicadores de confianza

Evaluación de contenidos por los motores de búsqueda

Como Google nos ha recordado, lo que cuenta no es el método de creación, sino la valor proporcionado. Los contenidos de la IA se evalúan del mismo modo que los demás contenidos, según la lógica E-E-A-T: experiencia, pericia, autoridad y fiabilidad. Por tanto, los contenidos generados por IA pueden estar bien referenciados, siempre que verificadas, contextualizadas y mejoradas por la experiencia humana.

El reto para los comunicadores ya no es evitar la IA, sino enmarcarlo para que pueda contribuir a la producción de contenidos de alto valor añadido.

Transparencia y reputación

Mencionar que la IA ha contribuido a la creación de un contenido no disminuye la confianza, al contrario. Esta transparencia se convierte en marcador serio y ética. Hoy en día, una empresa que oculta el uso que hace de la IA corre más riesgos de los que evita. La transparencia, la verificación y el control humano siguen siendo los pilares de una comunicación responsable potenciada por la IA.

La doble mirada

La revisión humana sigue siendo la mejor garantía de credibilidad. Permite corregir aproximaciones, validar la información, adaptar el tono, evitar sesgos y garantizar la coherencia con la estrategia global. Este doble enfoque -la IA para la productividad y el ser humano para la fiabilidad- define la nueva frontera de la comunicación responsable.

7 reflejos para una comunicación responsable con la IA

- Compruebe fuentes, cifras, citas, etc. generado por la IA antes de la emisión.

- Mencionar el uso de la IA cuando haya participado en la creación de un texto, visual, audio o vídeo.

- Revisión humana sistemática para validar el tono, el contenido y la coherencia.

- Actualice su carta interna de AI en consonancia con la evolución jurídica y tecnológica.

- Seguimiento de la reacción del público anticiparse a los malentendidos o críticas relacionados con la transparencia.

- No exponga nunca información confidencial ni datos personales en una herramienta de IA no validada por la organización.

- Conserve la prueba (registro) del uso de la IA.

-

Comprender los marcos reglamentarios, dominar las herramientas de IA y preservar la credibilidad de su comunicación requiere un desarrollo continuo de las competencias. ORSYS ofrece varios cursos de formación específicamente diseñados para apoyar a los comunicadores y community managers en estos nuevos usos.

- Gestión de comunidades: potencie su organización y comunicación con la IA

- Lo esencial para mejorar tu presencia en las redes sociales con IA

- IA para crear contenidos atractivos (texto, imágenes, vídeo)

Estos cursos forman parte de la oferta global de Academia ORSYS IA y formación en comunicación corporativa.

La IA no sustituye a la comunicación, sino que revela sus defectos y sus puntos fuertes. Utilizada metódicamente, se convierte en una herramienta de anticipación, creatividad y eficacia. Sin un marco, puede llevar a la confusión e incluso a la pérdida de confianza. La comunicación del mañana será híbrida: humana en la intención, aumentada en la forma. Y la diferencia entre innovación e imprudencia dependerá de la lucidez de los profesionales.