Het gebruik van kunstmatige intelligentie in bedrijfscommunicatie is niet langer een optie, maar een reflex. Maar je moet het wel doen zonder je geloofwaardigheid, je compliance... of je reputatie op het spel te zetten. Hoe kan AI, tussen de inwerkingtreding van de AI-wet, de regels die platforms opleggen en het misbruik dat al is vastgesteld, op een professionele, verantwoordelijke en transparante manier worden gebruikt? Frédéric Foschiani, expert op het gebied van sociale media en AI voor communicatie, legt uit welke voorzorgsmaatregelen je moet nemen om te profiteren van AI zonder de controle over je communicatie te verliezen.

Een bericht schrijven in luttele seconden, een originele visual genereren, sectortrends analyseren... Kunstmatige intelligentie is de favoriete assistent van communicatoren geworden. Maar achter de belofte van efficiëntie schuilt een complexere realiteit: verantwoordelijkheid. Elk stukje content dat wordt gegenereerd, elk stukje data dat wordt gebruikt of elk beeld dat wordt gewijzigd, brengt nu een verplichting tot transparantie met zich mee en stelt ons bloot aan juridische en vertrouwelijkheidsrisico's.

De inwerkingtreding van de Europese verordening inzake AI, de’AI-wet, en de nieuwe regels die de platforms opleggen, veranderen de praktijken ingrijpend. De vraag is dus niet langer moet AI worden gebruikt? Maar hoe kan het professioneel en verantwoord worden gebruikt? Tussen naleving, transparantie en geloofwaardigheid staat er veel op het spel. Het is een kwestie van maak van AI een hefboom voor kwaliteit, geen storende factor.

Inzicht in het nieuwe kader: de AI-wet en de gevolgen ervan

De AI-wet in de praktijk

De Europese Wet op de AI, die op 1 augustus 2024 van kracht wordt, is de eerste alomvattende, transversale en wettelijk bindende verordening die exclusief gewijd is aan AI. Het principe? Het classificeren van AI-systemen volgens vier risiconiveaus (onacceptabel, hoog, beperkt en minimaal), met stapsgewijze verplichtingen, met name op het gebied van transparantie voor bepaalde toepassingen. Sommige van deze bepalingen zijn al sinds februari 2025 van kracht. Dit zijn onder andere het verbod op AI-systemen die onaanvaardbare risico's met zich meebrengen en de eis van een «AI-cultuur» (AI-geletterdheid) als bedoeld in artikel 4 van de AI-wet.

Voorbeelden van onaanvaardbare risico's

Cognitieve en gedragsmatige manipulatie van mensen

AI-systemen die :

- psychologische of cognitieve gebreken uitbuiten

- gedrag manipuleren zonder dat de persoon zich daarvan bewust is

- fysieke of psychologische schade kan veroorzaken

Voorbeeld: een AI die een kwetsbaar individu (kind, fragiele persoon) subtiel tot gevaarlijk of zelfdestructief gedrag aanzet.

Uitbuiting van kwetsbare mensen

Verbod op AI die specifiek gericht is op :

- kinderen

- mensen met een handicap

- sociaal of economisch kwetsbare personen, met als doel hun beslissingen of gedrag te beïnvloeden

👉 Voorbeeld: intelligent speelgoed dat AI gebruikt om een kind aan te zetten tot het kopen van een product of tot bepaald gedrag.

Sociaal scoren op Chinese wijze

Systemen die :

- individuen beoordelen op basis van hun gedrag

- sociale, persoonlijke en gedragsgegevens met elkaar vergelijken

- leiden tot sancties, uitsluiting of discriminatie

👉 Voorbeeld: een «burgerwaardering» toekennen die de toegang tot huisvesting, een baan of een openbare dienst beïnvloedt.

Real-time biometrische identificatie op afstand (met zeer beperkte uitzonderingen)

Algemeen verbod op realtime gezichtsherkenning in openbare ruimtes voor massasurveillancedoeleinden.

⚠️ Er zijn zeer beperkte uitzonderingen voor wetshandhavers (terrorisme, vermiste personen, enz.), die onderworpen zijn aan strenge gerechtelijke controle.

👉 Voorbeeld van een verbod: automatisch scannen van gezichten in een straat of op een station om personen te identificeren zonder specifieke wettelijke basis.

HetAI-geletterdheid betreft iedereen die AI gebruikt in een professionele context: communicatie, marketing, HR, juridisch, financiën, enz. Het is niet beperkt tot sociale netwerken. Het is geen technische certificering, maar een middelenverplichting. Organisaties moeten ervoor zorgen dat hun teams de mogelijkheden, grenzen en risico's van AI begrijpen, evenals goede praktijken, met name op het gebied van betrouwbaarheid van content, vooringenomenheid en gevolgen voor de reputatie.

De specifieke vereisten voor AI-modellen voor algemene doeleinden zijn van toepassing sinds augustus 2025. De meeste vereisten, met name met betrekking tot transparantie, zullen volledig van kracht worden. 2 augustus 2026. Bepaalde vereisten worden dan geleidelijk ingevoerd tot 2027.

Voor communicatoren is deze tekst interessant. Het belicht een risico in verband met transparantie bij het maken van inhoud en online communicatie. Hoofdpunten: de AI-wet legt een versterkt bestuurskader op, met verplichtingen op het gebied van transparantie, traceerbaarheid en verantwoordingsplicht.

Gebrek aan transparantie: een juridisch en reputatierisico

In de artikelen 50 en 99 van de AI Act zijn twee belangrijke beginselen vastgelegd.

👉 Het publiek informeren . Wanneer inhoud is gegenereerd of aangepast door een AI, met name in het geval van realistische beelden, deepfakes of gesynthetiseerde stemmen.

👉 Inbreuken bestraffen. Tot € 35 miljoen of 7 % van de wereldwijde omzet voor bepaalde overtredingen (bijv. verboden praktijken) en tot € 15 miljoen of 3 % van de omzet voor andere, waaronder transparantieverplichtingen.

Praktisch gezien kan het publiceren van een door AI gegenereerde of aangepaste visual zonder dit te vermelden een risico op niet-naleving met zich meebrengen (AI-wet en platformregels), vooral als de content realistisch is en waarschijnlijk misleidend.

Voor bedrijven betekent dit een nieuwe redactionele verantwoordelijkheid. Ze moeten de herkomst van inhoud kunnen bewijzen en de aard ervan kunnen aannemen.

Deze transparantieverplichtingen zijn volledig van toepassing vanaf 2 augustus 2026. Tot die tijd moeten bedrijven op deze vereisten anticiperen via hun eigen rapportage- en etiketteringssystemen.

Etikettering bestaat uit het informeren van het publiek dat inhoud is gegenereerd of gewijzigd door een AI, waar deze informatie nodig is om verwarring met authentieke inhoud te voorkomen. Het is een hulpmiddel voor redactioneel bestuur en naleving van de regelgeving.

RGPD, CNIL en ethische consistentie

De CNIL, In zijn aanbevelingen voor 2025 herhaalt de Europese toezichthouder voor gegevensbescherming (EDPS) hoe belangrijk het is om individuen te informeren en hen in staat te stellen hun rechten effectief uit te oefenen in de context van AI-modellen, in overeenstemming met de GDPR.

Er staat meer op het spel dan alleen het juridische aspect: het beïnvloedt de digitaal vertrouwen.

Een communicatie die door AI wordt geproduceerd of ondersteund, moet aan dezelfde eisen voldoen als alle andere gegevens. Deze eisen hebben betrekking op waarheidsgetrouwheid, respect voor toestemming en afwezigheid van manipulatie. Hier ligt het verschil tussen verantwoord en onzorgvuldig gebruik.

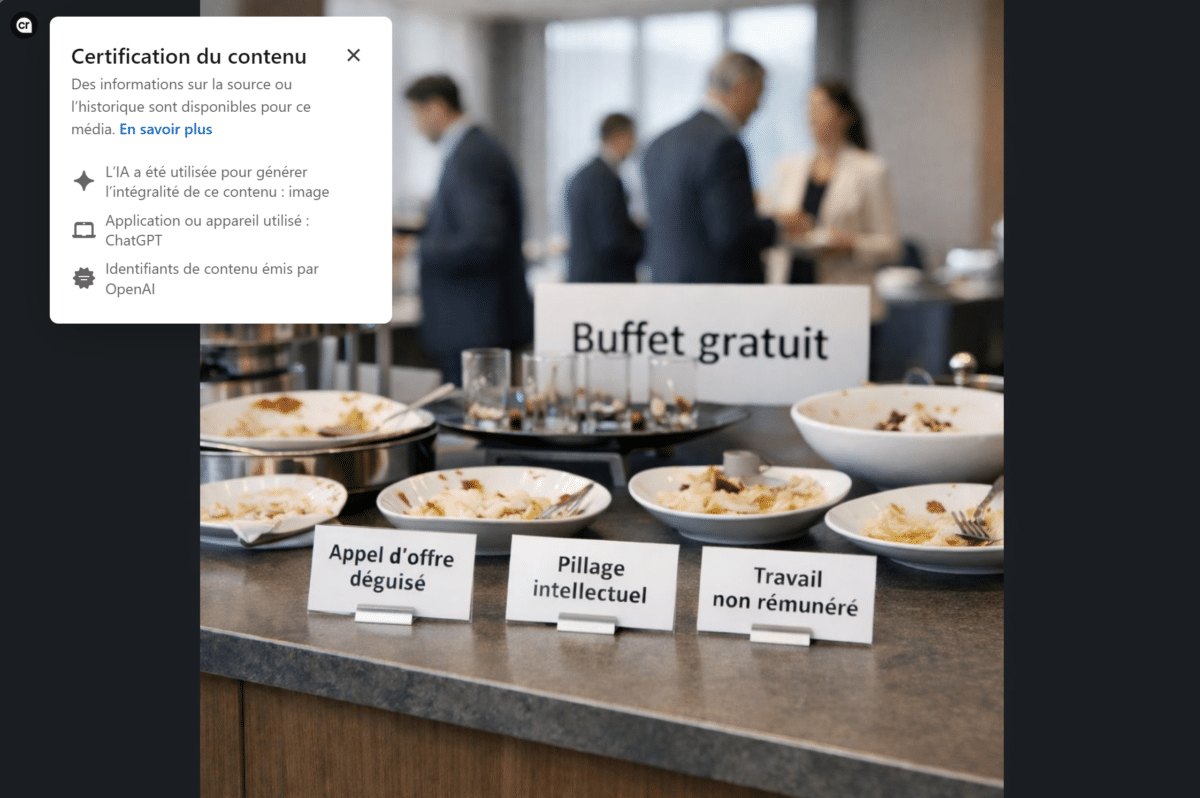

Platforms ondernemen actie: transparantie en controle

LinkedIn: content credentials gebruiken om de herkomst van content zichtbaar te maken

LinkedIn vertrouwt op de C2PA (Coalitie voor Inhoudsbewijzen en authenticiteit). Deze standaard werd gecreëerd door een consortium van technologie- en mediabedrijven (Adobe, BBC, Microsoft, Intel, enz.). Het geeft herkomstinformatie weer in de metadata van multimediabestanden.

Deze «inhoudsgegevens» geven aan of een afbeelding is gegenereerd of gewijzigd door AI. In sommige gevallen kunnen ze worden gebruikt om de bewerkingsgeschiedenis te achterhalen (naam van de auteur, gebruikt AI-platform). Elke afbeelding of video die door AI is gegenereerd, kan nu automatisch worden getagd om de herkomst of wijziging aan te geven.

Dit initiatief markeert een fundamentele verandering. Professionele sociale netwerken worden de bewakers van de betrouwbaarheid van publicaties, zoals vereist door de AI-wet. Deze informatie is niet altijd standaard zichtbaar. Toch is het een sterk signaal in termen van transparantie en redactionele verantwoordelijkheid op een professioneel netwerk.

Voor communicatoren versterkt dit de noodzaak om de traceerbaarheid van visuals te controleren en elke dubbelzinnigheid over de aard van de gepubliceerde inhoud te vermijden.

Meta en YouTube: labelen wordt de norm

Meta (Facebook, Instagram, Threads) heeft aangekondigd dat afbeeldingen die door AI zijn gemaakt automatisch worden gelabeld met behulp van ingesloten metagegevens (C2PA en IPTC).

Deze transparantiemaatregelen zijn bedoeld om gebruikers te informeren over de herkomst van inhoud. Ze zijn ook bedoeld om vertrouwen op te bouwen, in lijn met nieuwe wettelijke vereisten en het beleid van sociale netwerken.

Meta heeft in 2024 ook de terminologie van zijn labels gewijzigd om een duidelijker onderscheid te maken tussen inhoud «gemaakt met behulp van AI» en inhoud die «aanzienlijk gewijzigd» is. Het verklaarde doel is om het label leesbaarder te maken voor gebruikers, terwijl het vertrouwt op provenance-signalen in plaats van een eenvoudige handmatige verklaring.

YouTube, vereist nu de openbaarmaking van aanzienlijk gewijzigde of door AI gegenereerde inhoud als deze realistisch lijkt, met name als deze geloofwaardige personen, gebeurtenissen of situaties weergeeft.

Deze verplichting heeft expliciet betrekking op professioneel gebruik en is bedoeld om de risico's van misleiding of verkeerde informatie te beperken.

Het doel van deze praktijken is niet om creativiteit te beperken, maar om vertrouwen behouden. Transparantie wordt een nieuwe communicatiestandaard. Het is beter om de herkomst van inhoud te tonen dan om er over te twijfelen.

TikTok: zelfverklaring en automatische detectie

TikTok heeft ook de C2PA-standaard overgenomen en automatische labeling geïntroduceerd (auto-vlag) IA video's geïmporteerd van andere platforms. Inhoud gegenereerd door eigen tools wordt automatisch getagd. Deze filtering is ontworpen om valse informatie tegen te gaan, maar ook om merken beschermen. Want op een netwerk waar waargenomen authenticiteit de waarde van een bericht is, kan een fout in de etikettering of een te kunstmatig beeld de geloofwaardigheid snel ondermijnen.

Hoe je AI-gegenereerde inhoud herkent

Normen van oorsprong zoals C2PA of metagegevens IPTC spelen een sleutelrol bij het identificeren van inhoud die is gegenereerd door AI. Ze maken het mogelijk om informatie over de herkomst van een bestand, de gebruikte tools of de aangebrachte wijzigingen te integreren. Deze hulpmiddelen zijn echter niet onfeilbaar. Metadata kunnen worden verwijderd tijdens het opnieuw exporteren en niet alle tools implementeren ze op dezelfde manier.

Met andere woorden, de metadata IPTC/C2PA helpen bij het identificeren van de herkomst van inhoud. Maar ze kunnen nooit redactioneel bestuur of interne rapportagesystemen vervangen.

*IPTC (Internationale Raad voor de Perscommunicatie) is een internationaal orgaan dat de metadatastandaarden definieert die worden gebruikt door de media, persagentschappen en digitale platforms, waarbij informatie zoals auteur, datum en plaats van creatie, gebruiksrechten en, meer recent, indicaties gekoppeld aan inhoud gegenereerd of gewijzigd door kunstmatige intelligentie, rechtstreeks in bestanden (afbeeldingen, video's, documenten) worden geïntegreerd.

Integreer AI in uw strategie zonder uw reputatie en vertrouwelijkheid op het spel te zetten

AI als bondgenoot: optimaliseren zonder verantwoordelijkheid weg te nemen

Naast het maken van visuals en video's kan AI een formidabel hulpmiddel zijn voor de sector bewaking, berichten schrijven of de creatief ideeën genereren. Maar ze denkt niet na, controleert niet en begrijpt de context niet.

Voor elke publicatie moeten vier reflexen systematisch worden:

- Nooit persoonlijke gegevens of vertrouwelijke informatie invoeren (klanten, HR, contracten, financiële gegevens, strategie, enz.) in een AI-tool die niet door het bedrijf is gevalideerd, ook niet voor herformuleringsdoeleinden.

- AI verplichten om bronnen te vermelden (artikelen, studies, cijfers)

- Kruiscontroles en verificatie van gegevens geleverd door AI

- De toon aanpassen en het bericht de positionering van het bedrijf

Een AI kan een virale trend suggereren... maar alleen een communicator weet of het echt de strategie dient.

Stem van een expert - Frédéric Foschiani

«Ik gebruik AI regelmatig als hulpmiddel voor monitoring en redactionele ideeën. Maar één regel verandert nooit: er mogen geen gegevens, cijfers of citaten worden gebruikt zonder menselijke verificatie. AI kan invalshoeken of trends suggereren, maar al te vaak produceert het content die geloofwaardig is... maar onjuist. Het voorbeeld van Deloitte illustreert dit risico perfect. In een professionele context zal het publiceren van foutieve informatie de verantwoordelijkheid en geloofwaardigheid van de auteur en zijn bedrijf in het gedrang brengen».»

Een intern gebruikershandvest formaliseren

Het implementeren van een intern AI-handvest is nu een goede praktijk, zoals aanbevolen in artikel 4 van de AI-wet (AI-geletterdheid).

In het bijzonder moet de :

- geautoriseerd gereedschap

- aanvaardbare toepassingen

- vertrouwelijkheidsregels die van toepassing zijn op het gebruik van AI-instrumenten

- traceerbaarheids- en etiketteringsregels voor inhoud die is gegenereerd of gewijzigd door AI

- vermeldingen die moeten worden weergegeven wanneer inhoud wordt gegenereerd of gewijzigd door een AI

- behoefte aan systematisch menselijk onderzoek

Sommige bedrijven hebben dit kader al geformaliseerd en gaan zelfs zover dat ze een «IA-procedure voor openbaarmaking» hebben opgenomen voor hun publicaties, met name op sociale netwerken.

Dit interne systeem is bedoeld om het publiek of gebruikers te informeren wanneer inhoud is gegenereerd of gewijzigd door kunstmatige intelligentie, om verwarring met menselijke productie of authentieke informatie te voorkomen. Dit type initiatief getuigt van een volwassen aanpak: technologie wordt geïntegreerd in de praktijk, maar nooit zonder controle gebruikt.

Stem van een expert - Frédéric Foschiani

«Deze behoefte aan een kader is niet theoretisch. Het komt heel concreet uit de praktijk naar voren. Als ik ondersteuning geef, merk ik dat de meest voorkomende fout niet het gebruik van AI is, maar het ontbreken van een raamwerk. Steeds meer bedrijven stellen interne AI-oplossingen beschikbaar om de risico's te beperken die gepaard gaan met het verspreiden van gevoelige of vertrouwelijke gegevens buiten de organisatie. Deze tools worden echter vaak ingezet zonder echte ondersteuning voor de teams op het gebied van best practices. Medewerkers hebben de technologie, maar niet altijd de begeleiding die ze nodig hebben om deze effectief en verantwoord te gebruiken. Dit geldt zowel voor het onder de knie krijgen van prompting - weten hoe je een duidelijk verzoek formuleert om snel een bruikbaar resultaat te krijgen - als voor het begrijpen van de grenzen van AI, de vooroordelen of de wettelijke verplichtingen die moeten worden nageleefd in een professionele context, met name op het gebied van transparantie en traceerbaarheid van content. Zonder dit kader wordt AI een onderbenut hulpmiddel of, omgekeerd, een vermijdbare risicofactor voor de communicatie en reputatie van een bedrijf».»

Anticiperen op communicatiefouten en -crises

De recente geschiedenis staat bol van voorbeelden waarin AI de communicatie waarvoor het was bedoeld, heeft verraden. Zo publiceerde een bedrijf een door AI gegenereerde afbeelding van een medisch team om een campagne te illustreren. Internetgebruikers ontdekten al snel de kunstmatigheid van de afbeelding: anatomische fouten, wazige gezichten en inconsistente details. Als gevolg daarvan werd het bedrijf beschuldigd van het verkeerd voorstellen en uitbuiten van mensen. Zelfs buiten sociale netwerken herinnert dit soort fouten ons aan de noodzaak van waakzaamheid.

Oktober 2025, Deloitte is gedwongen de Australische overheid terug te betalen nadat het een rapport had ingediend dat vol zat met door AI gegenereerde fouten. Er werden valse referenties, onnauwkeurige juridische citaten en inconsistenties gevonden die werden toegeschreven aan het ongecontroleerde gebruik van generatieve AI-tools. Dit voorbeeld illustreert een belangrijk punt: een fout gegenereerd door AI wordt altijd een menselijke fout.

Te plannen acties :

- training in het juiste gebruik van AI om vooroordelen en risico's te begrijpen

- het beheersen van prompting om zo nauwkeurig mogelijk te zijn in de instructies die aan de AI worden gegeven

- een strikt validatieprotocol (proeflezen, bronnen controleren, consistentie testen)

- een plan voor crisisrespons, inclusief berichten ter verduidelijking, openbare rectificaties en transparantie over de oorsprong van de fout

- een register van AI-gegenereerde inhoud om traceerbaarheid te garanderen

Een AI-fout, of die nu intern of extern is, op een website of in een bericht, wordt vroeg of laat altijd een fout, een communicatiefout. Controle- en reactieprocessen zijn geen optie: ze vormen het vangnet van elke verantwoorde AI-strategie.

Geloofwaardigheid, kwaliteit en SEO: de nieuwe vertrouwensindicatoren

Evaluatie van inhoud door zoekmachines

Zoals Google ons eraan heeft herinnerd, is het niet de methode van creatie die telt, maar de geleverde waarde. AI-inhoud wordt op dezelfde manier beoordeeld als andere inhoud, volgens de E-E-A-T-logica: ervaring, deskundigheid, autoriteit en betrouwbaarheid. Inhoud die wordt gegenereerd door AI kan daarom goed worden gerefereerd, mits deze geverifieerd, gecontextualiseerd en verbeterd door menselijke expertise.

De uitdaging voor communicatoren is niet langer om AI te vermijden, maar om kader het zodat het kan bijdragen aan de productie van inhoud met een hoge toegevoegde waarde.

Transparantie en reputatie

Vermelden dat AI heeft bijgedragen aan de creatie van een stuk content vermindert het vertrouwen niet - integendeel. Deze transparantie wordt een serieuze marker en ethiek. Een bedrijf dat het gebruik van AI vandaag verbergt, neemt meer risico's dan het vermijdt. Transparantie, verificatie en menselijke controle blijven de pijlers van verantwoorde communicatie versterkt door AI.

De dubbele look

Menselijk proeflezen blijft de beste garantie voor geloofwaardigheid. Het stelt ons in staat om benaderingen te corrigeren, informatie te valideren, de toon aan te passen, vooringenomenheid te vermijden en consistentie met de algemene strategie te garanderen. Deze dubbele benadering - AI voor productiviteit en mens voor betrouwbaarheid - definieert de nieuwe grens van verantwoorde communicatie.

7 reflexen voor verantwoorde communicatie met AI

- Controleer bronnen, cijfers, citaten, enz. gegenereerd door de AI voor uitzending.

- Vermeld het gebruik van AI wanneer het heeft deelgenomen aan de creatie van een tekst, beeld, geluid of video.

- Systematisch menselijk proeflezen om toon, inhoud en consistentie te valideren.

- Werk uw interne IA charter bij in lijn met wettelijke en technologische ontwikkelingen.

- De reactie van het publiek volgen om te anticiperen op misverstanden of kritiek in verband met transparantie.

- Geef nooit vertrouwelijke informatie of persoonlijke gegevens vrij in een AI-tool die niet door de organisatie is gevalideerd.

- Bewaar het bewijs (register) van het gebruik van AI.

Laat je trainen!

Het begrijpen van de regelgevingskaders, het beheersen van AI-tools en het behouden van de geloofwaardigheid van uw communicatie vereist voortdurende ontwikkeling van vaardigheden. ORSYS biedt verschillende trainingen die speciaal zijn ontworpen om communicators en community managers te ondersteunen bij deze nieuwe toepassingen.

- Community management: versterk je organisatie en communicatie met AI

- De essentie voor het verbeteren van je aanwezigheid op sociale netwerken met behulp van AI

- AI om boeiende inhoud te maken (tekst, afbeeldingen, video)

Deze cursussen maken deel uit van het totale aanbod van ORSYS IA Academie En training bedrijfscommunicatie.

AI is geen vervanging voor communicatie; het onthult de gebreken en sterke punten ervan. Als het methodisch wordt gebruikt, wordt het een hulpmiddel voor anticipatie, creativiteit en efficiëntie. Zonder een kader kan het leiden tot verwarring en zelfs verlies van vertrouwen. De communicatie van morgen zal hybride zijn: menselijk qua intentie, uitgebreid qua vorm. En het verschil tussen innovatie en onvoorzichtigheid zal afhangen van de helderheid van de professionals.