Gracias a los nuevos modelos de IA generativa, los robots ya no se limitan a ejecutar órdenes. Perciben, interpretan e interactúan con su entorno. Se trata de un avance espectacular que augura la llegada de robots multifuncionales capaces de realizar tareas complejas. Repasamos estos avances y las competencias que hay que desarrollar para apropiarse de estas tecnologías.

Cuando la IA generativa transforma la robótica: demostraciones espectaculares

El retorno del turco mecánico en la era de la IA.

A principios de noviembre, el fabricante chino de automóviles Xpeng presentó su robot humanoide Iron. La fluidez de sus movimientos suscita tanto fascinación como escepticismo en las redes sociales. Los internautas claman inmediatamente que se trata de un engaño, sospechando que hay un humano escondido dentro de la máquina, al igual que en el caso del Turco mecánico, el famoso autómata falso que jugaba al ajedrez.

Para acabar con los rumores, Xpeng responde con un segundo vídeo. En él se ve a un asistente cortando las capas de tela que cubren la pierna del robot para dejar al descubierto sus mecanismos internos... sin ningún humano escondido.

Este tipo de demostraciones impactantes se multiplicarán con los avances de los últimos meses en robótica. Al igual que en muchos otros campos, Este salto disruptivo se debe a la IA generativa..

Pero aquí, el objetivo no es generar texto o imágenes. Se trata más bien de dotar a los robots de nuevas capacidades motoras y sensoriales.. Esto les permite comprender mejor su entorno y ganar en autonomía y versatilidad.

©Xpeng

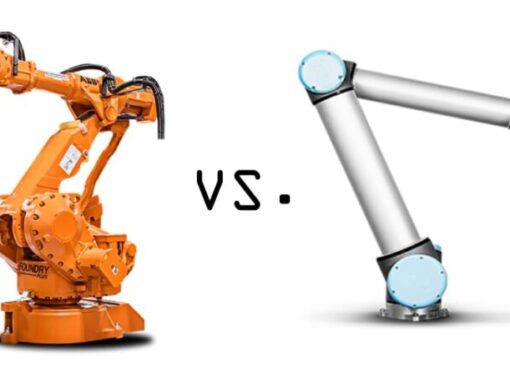

Robots programados manualmente... a modelos autónomos

Los límites de la programación tradicional

«Actualmente, la programación de robots es una tarea extremadamente compleja, avance Stéphane Doncieux, director del ISIR (Instituto de Sistemas Inteligentes y Robótica) y profesor de informática en la Universidad de la Sorbona-CNRS. Cada comportamiento que debe ejecutar un robot debe ser programado explícitamente por un ingeniero, que debe pensar en cada acción requerida, en las condiciones de ejecución y en las reacciones adecuadas en caso de que se produzca un evento inesperado.

Esta restricción explica por qué los robots industriales están condenados a realizar la misma tarea infinitamente en las cadenas de montaje de los fabricantes de automóviles o de los actores de la industria manufacturera, aunque en teoría sean reprogramables y cada vez más colaborativos.

Más recientemente, estos robots se han dotado de algoritmos de visión para detectar y clasificar las piezas defectuosas en una cadena de producción. «Este caso de uso sigue estando limitado a contextos altamente controlados»., continúa Stéphane Doncieux. En este tipo de escenario, conocemos con precisión el tipo de piezas que entran y salen.. "

Los robots domésticos: un primer paso hacia la autonomía

En el ámbito doméstico, los robots aspiradores o cortacéspedes evolucionan en un entorno menos controlado que en las fábricas. Sin embargo, las tareas que deben realizar son lo suficientemente sencillas como para expresarse mediante comportamientos elementales. Cuando encuentra un obstáculo, el robot doméstico cambia de trayectoria y continúa su camino.

La contribución de la IA generativa a la robótica

La nueva generación de robots potenciados con IA realiza manipulaciones mucho más sofisticadas. Para ilustrar las aportaciones de la IA generativa, Cédric Vasseur, experto en inteligencia artificial y robótica y formador en ORSYS, aconseja a sus alumnos que vean los vídeos de demostración de los robots humanoides de Figura AI.

«Demuestran de manera concreta lo que se puede lograr hoy en día, ya sea en reconocimiento visual o textual».. En uno de estos vídeos, se ve a un robot colocando con delicadeza platos, cuencos y vasos en un lavavajillas.

La contribución de los nuevos modelos VLM y VLA para los robots

Para lograr tales hazañas, los ingenieros robóticos recurren a derivados de los famosos LLM.

Las VLM (Modelos de lenguaje visual) permiten al robot relacionar imágenes y lenguaje. Mientras que los VLA (Visión Lenguaje Acción) transforman estas percepciones en movimientos coordinados.

Resultado : con estos modelos, un robot ahora puede comprender una instrucción en lenguaje natural, observar una escena y luego actuar.

Equipado con múltiples sensores (de flexión, temperatura, ultrasonidos), cámaras 3D RGB-D (que combinan datos de color (RGB) y profundidad (D)) o lidares, el robot recoge información del exterior y adapta su comportamiento en consecuencia.

Los modelos VLA convierten estos datos visuales y textuales en comandos motores. Para Stéphane Doncieux, se trata de ampliar las posibilidades de las herramientas de IA generativa a la robótica. «El objetivo es crear modelos lo suficientemente generales como para comprender un entorno, recibir instrucciones en lenguaje natural y permitir que el robot realice las acciones necesarias para llevar a cabo la tarea solicitada».»

El robot que llena el lavavajillas: un ejemplo emblemático

El vídeo de demostración anterior de Figura AI muestra un robot capaz de manipular platos, vasos o cubiertos con una precisión sorprendente.

Lo que puede parecer trivial para un humano —llenar un lavavajillas— presenta, de hecho, una gran complejidad para un robot. « Agarrar y manipular un objeto no solo requiere visión, sino también el anclaje en el cuerpo del robot, lo que exige una destreza manual suficiente, posiblemente retroalimentación táctil y muchos otros factores mucho más complejos que un juego de estrategia. », continúa Stéphane Doncieux. La máquina puede ganar al hombre al ajedrez y al juego del go, pero tiene grandes dificultades para agarrar y abrir una cantimplora.

Es la famosa paradoja de Moravec que se resume en la idea de que «lo más difícil en robótica suele ser lo más fácil para el ser humano».

©Tesla

Hacia modelos fundamentales... para los robots

La época en la que cada robot tenía que aprender por sí solo está llegando a su fin. Están surgiendo nuevos modelos denominados «fundamentales», capaces de asimilar la experiencia de múltiples máquinas.

VLA genéricos como RT-2 — pronto sustituido por versiones más amplias — o Isaac GR00T de Nvidia, o incluso Helix de Figure AI, amplían las capacidades basándose en datos procedentes de una multitud de entornos.

Los modelos abiertos como OpenVLA completan este ecosistema, permitiendo la adaptación a diversos brazos, plataformas móviles o prototipos humanoides.

La idea es sencilla: en lugar de entrenar a un robot, se entrena la propia habilidad y luego se distribuye de un robot a otro..

Datos, simulación y «modelos mundiales»: los nuevos combustibles de esta revolución

Un déficit de datos robóticos

Entrenar los modelos para la extrema variabilidad del mundo real requiere, además, un volumen considerable de datos. Desarrollados por Boston Dynamics, Google, Xpeng o Nvidia, los modelos VLA incluyen miles de millones de parámetros que deben alimentarse.

Sin embargo, mientras que los modelos «tradicionales» de IA generativa tienen un amplio acceso a corpus de textos y bancos de imágenes, los datos robóticos son mucho más limitados.

Para paliar este déficit, Los ingenieros robóticos construyen grandes conjuntos de datos multirrobots., por ejemplo, fruto de colaboraciones entre laboratorios e industriales. Otra solución: utilizar masivamente la generación de datos sintéticos, a través de simuladores físicos y «modelos mundiales» capaces de crear entornos virtuales casi infinitos, como Genio 3 de Google DeepMind o las herramientas de simulación de Nvidia.

La idea es exponer los modelos a una diversidad de situaciones imposibles de reproducir únicamente con robots físicos en laboratorios.

Numerosos retos que afrontar en el mundo real

Hay otros retos que deben superarse, esta vez en el mundo real. El control del movimiento robótico es un arte delicado.

Si bien es fácil indicarle al robot que coloque su brazo a la altura del tapón de una cantimplora, pedirle que gire dicho tapón con su pinza supone ejercer una cierta presión en el ángulo adecuado. « Los gestos cotidianos requieren modos de control que no solo implican la posición, lo que hace que el control del movimiento sea más complicado de lo que parece», señala Stéphane Doncieux.

Por su parte, Cédric Vasseur advierte contra la ilusión que dan algunos vídeos de demostración: están grabados en un estudio con una iluminación óptima, sin elementos perturbadores que puedan interferir con el robot o su sistema de visión. « Los objetos manipulados tienen colores muy contrastados para facilitar su identificación por parte de la IA. ». El robot también pudo ser entrenado para un entorno determinado. Retomando el ejemplo del lavavajillas, un robot aprendió durante horas a vaciarlo en una cocina específica. Pero si lo trasladas a otra cocina, hay que volver a enseñarle todo.

Cuestiones de seguridad, ética... y normativa

Seguridad física y ciberseguridad

Antes de que los robots domésticos lleguen a nuestros hogares, la industria será el primer ámbito en implementarlos, según Cédric Vasseur.

" Ya hay muchos proyectos en marcha en Europa, especialmente en Alemania, donde grandes grupos industriales están trabajando en el uso de robots humanoides. Además, actores del comercio electrónico, como Amazon o Alibaba, están invirtiendo masivamente en la creación de almacenes totalmente automatizados, basados en autómatas, cintas transportadoras o transportadores automatizados.

©Agility Robotics

La puesta en producción de este tipo de robot avanzado plantea una serie de riesgos. En primer lugar, los relacionados con la seguridad. Al convertirse en comunicativa, la máquina aumenta su superficie de ataque. " Si un robot responde a cualquier comando de voz, podría dañar a otras personas y realizar actos potencialmente maliciosos o ilegales. », alerta Stéphane Doncieux. A estos riesgos cibernéticos se suman riesgos físicos imprevisibles. El robot se enfrenta a todos los imprevistos del mundo real o puede ser objeto de un acto de sabotaje.

Ética: responsabilidad y competencias humanas

Nuestros dos expertos también plantean cuestiones éticas y sociales que supondría una generalización de los robots potenciados con IA. Stéphane Doncieux menciona una pérdida de responsabilidad – ante herramientas que parecen ser pertinentes la mayor parte del tiempo, sus usuarios pueden verse tentados a dejarles decidir de forma autónoma, sin asumir la responsabilidad de las decisiones tomadas y, como consecuencia, perder competencias.

También habrá que lidiar con las expectativas de los empleados sobre las condiciones de introducción de estos robots en su lugar de trabajo.

Regulación: la Ley de IA

También hay que tener en cuenta la normativa, con los marcos reglamentarios emergentes, ya sea en materia de seguridad de las máquinas o de normativas especializadas en IA. En Europa, con la Ley de IA, los robots dotados de IA avanzada se convierten en sistemas de alto riesgo. Este estatus impone una disciplina estricta: auditorías, documentación completa, transparencia de los modelos, seguimiento continuo y ciberseguridad reforzada.

No se trata de una restricción artificial: cuanto más aprenden los robots, más deben demostrar que siguen siendo fiables, predecibles y seguros.

¿Qué formación se necesita para la robótica avanzada?

El ingeniero robótico de 2025 ya no tiene el mismo rostro que el de 2015. Conoce ROS 2 como la palma de su mano, comprende la visión industrial avanzada y maneja simuladores como Isaac Lab con la misma facilidad con la que un supervisor maneja su presostato. También sabe entrenar un modelo de imitación, interpretar los resultados de un sistema de visión y diagnosticar un fallo de aprendizaje.

La programación sigue siendo indispensable, pero ya no es fundamental: lo que importa ahora es la capacidad de organizar procesos complejos en los que la percepción, la IA y la mecánica deben interactuar a la perfección.

«Para trabajar en este tipo de proyectos, es importante ser versátil y desarrollar un gran número de habilidades que combinen la robótica y la inteligencia artificial»., apoya a Cédric Vasseur.

Las formaciones ORSYS

ORSYS ofrece seminarios sobre el estado actual de la técnica. Dirigidos a responsables de la toma de decisiones y jefes de proyecto, permiten hacer un balance de los últimos avances en este campo.

Es el caso de la formación «Robótica, estado actual» (ROB), que repasa las aplicaciones pasadas, presentes y futuras de la robótica y las aportaciones de la IA.

Para los responsables de la toma de decisiones y los jefes de proyecto, otro seminario presenta las soluciones de IA generativa del mercado y sus usos (IAP). También existe una formación más específica sobre IA y robótica al servicio de la salud (IAZ).

Para perfiles más técnicos, hay talleres que se centran en tecnologías como ROS (Robot Operating System), que permite crear aplicaciones robóticas (ROH), o el taller formativo «Inteligencia artificial, algoritmos útiles aplicados a la robótica» (IAG). Estos recorridos permiten comprender de manera concreta cómo explotar los nuevos modelos VLM/VLA, la simulación y las herramientas de código abierto en proyectos reales.

«El dominio de la programación sigue siendo imprescindible»., continúa Cédric Vasseur. Independientemente de la naturaleza del robot desarrollado, en algún momento habrá que programarlo.. » Los conocimientos en diseño 3D también son esenciales, tanto para el diseño como para comprender las limitaciones físicas a las que estará sometido el robot.

Por otra parte, la gestión de proyectos es una competencia clave. «Un proyecto de robótica es complejo»., añade el formador. Implica diferentes oficios y la coordinación de numerosos componentes y periféricos.» En lo que respecta a la parte puramente robótica, es esencial dominar tanto las habilidades mecánicas como las electrónicas. « Algunas operaciones se realizan a mano cuando se trata de soldar o diseñar un circuito electrónico propio.»

La seguridad: la de los robots, pero también la de la IA

En lo que respecta a la seguridad, Cédric Vasseur imparte un módulo de formación de un día centrado en la inteligencia artificial y la seguridad operativa (ICY). Los participantes descubren cómo protegerse frente a las nuevas amenazas relacionadas con la IA, tanto en el mundo virtual como en el físico. Por último, el experto ha coescrito un libro blanco, publicado por ORSYS, sobre la IA y la ciberseguridad para profundizar en este tema. En un contexto en el que los robots y la IA generativa convergen, esta competencia en materia de seguridad cobra una importancia fundamental desde el momento del diseño de los sistemas.

Los robots potenciados con IA generativa ya no se limitan a ejecutar, sino que deciden y se adaptan. Ahora nos corresponde a nosotros comprender sus límites, garantizar la seguridad de su uso y formarnos para mantener el control sobre este nuevo poder industrial.

©UBTech