Utiliser l’intelligence artificielle dans sa communication professionnelle n’est plus une option, mais un réflexe. Encore faut-il le faire sans risquer sa crédibilité, sa conformité… ou sa réputation. Entre l’entrée en vigueur de l’AI Act, les règles imposées par les plateformes et les dérives déjà observées, comment utiliser l’IA de façon professionnelle, responsable et transparente ? Frédéric Foschiani, expert en médias sociaux et en IA pour la communication, décrypte les précautions indispensables pour tirer parti de l’IA sans perdre le contrôle de sa communication.

Rédiger un post en quelques secondes, générer un visuel original, analyser les tendances d’un secteur… L’intelligence artificielle est devenue l’assistante favorite des communicants. Mais derrière la promesse d’efficacité se cache une réalité plus complexe : celle de la responsabilité. Chaque contenu généré, chaque donnée utilisée ou chaque image modifiée engage désormais une obligation de transparence et expose à un risque juridique et de confidentialité.

L’entrée en vigueur du règlement européen sur l’IA, l’AI Act, et les nouvelles règles imposées par les plateformes changent profondément les usages. La question n’est donc plus faut-il utiliser l’IA ? Mais comment l’utiliser de manière professionnelle et responsable ? Entre conformité, transparence et crédibilité, l’enjeu est clair. Il s’agit de faire de l’IA un levier de qualité et non pas un facteur de confusion.

Comprendre le nouveau cadre : l’AI Act et ses impacts

L’AI Act en pratique

Entré en vigueur le 1ᵉʳ août 2024, l’AI Act européen constitue la première réglementation globale, transversale et juridiquement contraignante exclusivement dédiée à l’IA. Son principe ? Classer les systèmes d’IA selon quatre niveaux de risque (inacceptable, élevé, limité et minimal), avec des obligations graduées, notamment en matière de transparence pour certains usages. Depuis février 2025, certaines dispositions sont déjà effectives. C’est notamment le cas de l’interdiction des IA présentant des risques inacceptables et l’obligation de « culture IA » (AI literacy) prévue à l’article 4 de l’AI Act.

Exemples de risques inacceptables

Manipulation cognitive et comportementale des personnes

Sont interdits les systèmes d’IA qui :

- exploitent des failles psychologiques ou cognitives

- manipulent le comportement sans que la personne en ait conscience

- peuvent causer un préjudice physique ou psychologique

👉 Exemple : une IA qui pousse subtilement un individu vulnérable (enfant, personne fragile) à adopter un comportement dangereux ou autodestructeur.

Exploitation des personnes vulnérables

Interdiction des IA qui ciblent spécifiquement les :

- enfants

- personnes en situation de handicap

- individus socialement ou économiquement vulnérables, dans le but d’influencer leurs décisions ou comportements

👉 Exemple : un jouet intelligent utilisant l’IA pour inciter un enfant à acheter un produit ou à adopter un comportement précis.

Le social scoring à la manière chinoise

Sont interdits les systèmes qui :

- évaluent ou notent des individus sur la base de leur comportement

- croisent des données sociales, personnelles ou comportementales

- entraînent des sanctions, exclusions ou discriminations

👉 Exemple : attribuer une « note de citoyen » influençant l’accès à un logement, un emploi ou un service public.

Identification biométrique à distance en temps réel (avec exceptions très encadrées)

Interdiction générale de la reconnaissance faciale en temps réel dans l’espace public à des fins de surveillance de masse.

⚠️ Des exceptions très limitées existent pour les forces de l’ordre (terrorisme, personnes disparues…), sous contrôle judiciaire strict.

👉 Exemple d’interdiction : scanner automatiquement les visages dans une rue ou une gare pour identifier des individus sans base légale spécifique.

L’AI literacy concerne toutes les personnes qui utilisent l’IA dans un cadre professionnel : communication, marketing, RH, juridique, finance, etc. Elle ne se limite pas aux réseaux sociaux. Il ne s’agit pas d’une certification technique, mais d’une obligation de moyens. Les organisations doivent en effet s’assurer que leurs équipes comprennent les capacités, les limites, les risques de l’IA et les bonnes pratiques, notamment en matière de fiabilité des contenus, de biais et d’impact réputationnel.

Les obligations spécifiques concernant les modèles d’IA à usage général s’appliquent depuis août 2025. La majorité des exigences, notamment en matière de transparence, entreront pleinement en vigueur le 2 août 2026. Certaines exigences s’échelonnent ensuite jusqu’en 2027.

Pour les communicants, ce texte est intéressant. Il met en effet en évidence un risque lié à la transparence dans la création de contenus et la communication en ligne. À retenir : l’AI Act impose un cadre de gouvernance renforcé, incluant des obligations de transparence, de traçabilité et de responsabilité.

Manquer de transparence : un risque juridique et réputationnel

Les articles 50 et 99 de l’AI Act fixent deux principes majeurs.

👉 Informer le public . Lorsqu’un contenu a été généré ou modifié par une IA, notamment s’il s’agit de visuels réalistes, de deepfakes ou de voix de synthèse.

👉 Sanctionner les manquements. Jusqu’à 35 millions d’euros ou 7 % du chiffre d’affaires mondial pour certaines infractions (ex. pratiques interdites) et jusqu’à 15 millions d’euros ou 3 % du chiffre d’affaires pour d’autres, dont les obligations de transparence.

Concrètement, publier un visuel généré ou modifié par IA sans le mentionner peut déclencher un risque de non-conformité (AI Act et règles des plateformes), surtout si le contenu est réaliste et susceptible de tromper.

Pour les entreprises, c’est une nouvelle responsabilité éditoriale. Elles doivent être capables de prouver l’origine d’un contenu et d’en assumer la nature.

Ces obligations de transparence seront pleinement applicables à partir du 2 août 2026. D’ici là, les entreprises doivent anticiper ces exigences à travers leurs propres dispositifs de signalement et d’étiquetage.

L’étiquetage consiste à informer le public qu’un contenu a été généré ou modifié par une IA, dès lors que cette information est nécessaire pour éviter toute confusion avec un contenu authentique. C’est un outil de gouvernance éditoriale et de conformité réglementaire.

RGPD, CNIL et cohérence éthique

La CNIL, dans ses recommandations de 2025, rappelle notamment l’importance d’informer les personnes et de permettre l’exercice effectif de leurs droits dans le contexte des modèles d’IA, en cohérence avec le RGPD.

L’enjeu dépasse le seul aspect juridique : il touche à la confiance numérique.

Une communication produite ou assistée par IA doit respecter les mêmes exigences que toute autre donnée. Ces exigences concernent la véracité, le respect du consentement et l’absence de manipulation. C’est donc là que se joue la différence entre un usage responsable et un usage imprudent.

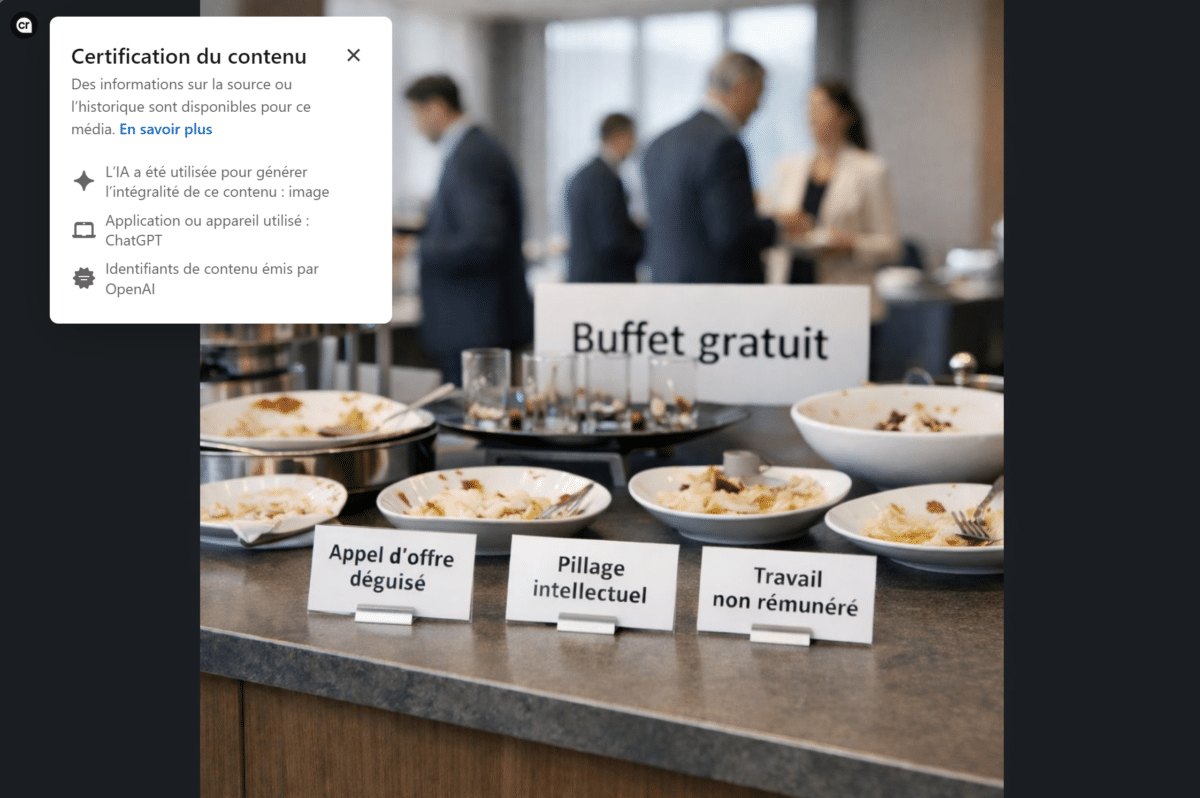

Les plateformes passent à l’action : transparence et contrôle

LinkedIn : rendre visible l’origine des contenus grâce aux content credentials

LinkedIn s’appuie sur le standard C2PA (Coalition for Content Provenance and Authenticity). Ce standard a été créé par un consortium d’entreprises tech et de médias (Adobe, BBC, Microsoft, Intel…). Il affiche des informations de provenance dans les métadonnées des fichiers multimédias.

Ces « content credentials » permettent d’indiquer si une image a été générée ou modifiée par IA. Dans certains cas, ils permettent d’en retracer l’historique d’édition (nom de l’auteur, plateforme d’IA utilisée). Chaque image ou vidéo générée par IA peut donc désormais être automatiquement marquée, indiquant son origine ou sa modification.

Cette initiative marque une évolution de fond. Les réseaux sociaux professionnels deviennent garants de la fiabilité des publications, comme exigée par l’AI Act. Ces informations ne sont pas toujours visibles par défaut. Elles constituent néanmoins un signal fort en matière de transparence et de responsabilité éditoriale sur un réseau professionnel.

Pour les communicants, cela renforce la nécessité de maîtriser la traçabilité des visuels et d’éviter toute ambiguïté sur la nature du contenu publié.

Meta et YouTube : l’étiquetage devient la norme

Meta (Facebook, Instagram, Threads) a annoncé l’étiquetage automatique des images créées par IA à partir des métadonnées intégrées (C2PA et IPTC).

Ces dispositifs de transparence visent à informer les utilisateurs sur l’origine des contenus. Ils visent aussi à renforcer la confiance, conformément aux nouvelles exigences réglementaires et aux politiques des réseaux sociaux.

Meta a par ailleurs fait évoluer la terminologie de ses labels en 2024 afin de distinguer plus clairement les contenus « créés avec l’aide de l’IA » de ceux « significativement altérés ». L’objectif affiché est de renforcer la lisibilité pour les utilisateurs, tout en s’appuyant sur des signaux de provenance plutôt que sur une simple déclaration manuelle.

YouTube, de son côté, impose désormais la divulgation des contenus significativement modifiés ou générés par IA lorsqu’ils paraissent réalistes, en particulier s’ils représentent des personnes, des événements ou des situations crédibles.

Cette obligation concerne explicitement les usages professionnels et vise à limiter les risques de tromperie ou de désinformation.

Ces pratiques ne visent pas à restreindre la créativité, mais à préserver la confiance. La transparence devient un nouveau standard de communication. Mieux vaut afficher l’origine d’un contenu que laisser planer le doute.

TikTok : l’autodéclaration et la détection automatique

TikTok a également adopté le standard C2PA et introduit l’étiquetage automatique (auto-flag) des vidéos IA importées depuis d’autres plateformes. Les contenus générés par ses propres outils sont automatiquement étiquetés. Ce filtrage vise à lutter contre les fausses informations, mais aussi à protéger les marques. Car, sur un réseau où l’authenticité perçue fait la valeur d’un message, une erreur d’étiquetage ou un visuel trop artificiel peut rapidement nuire à la crédibilité.

Comment identifier les contenus générés par l’IA

Les standards de provenance comme C2PA ou les métadonnées IPTC* jouent un rôle clé dans l’identification des contenus générés par IA. Ils permettent d’intégrer des informations sur l’origine d’un fichier, les outils utilisés ou les modifications apportées. Toutefois, ces dispositifs ne sont pas infaillibles. Les métadonnées peuvent être supprimées lors d’une réexportation et tous les outils ne les implémentent pas de manière homogène.

Autrement dit, les métadonnées IPTC/C2PA aident à identifier l’origine d’un contenu. Mais elles ne remplacent jamais une gouvernance éditoriale ni des dispositifs internes de signalement.

*IPTC (International Press Telecommunications Council) est un organisme international qui définit les standards de métadonnées utilisés par les médias, agences de presse et plateformes numériques en intégrant directement dans les fichiers (images, vidéos, documents), des informations telles que : l’auteur, la date et le lieu de création, les droits d’usage et, plus récemment, des indications liées aux contenus générés ou modifiés par l’intelligence artificielle.

Intégrer l’IA dans sa stratégie sans risquer sa réputation et la confidentialité

L’IA comme alliée : optimiser sans se déresponsabiliser

Au-delà de la création de visuels et de vidéos, l’IA peut être un formidable outil pour la veille sectorielle, la rédaction de posts ou la génération d’idées créatives. Mais elle ne pense pas, ne vérifie pas et ne comprend pas le contexte.

Avant toute publication, quatre réflexes doivent devenir systématiques :

- Ne jamais saisir de données personnelles ou d’informations confidentielles (clients, RH, contrats, données financières, stratégie…) dans un outil d’IA non validé par l’entreprise, y compris à des fins de reformulation

- Obliger l’IA à citer ses sources (articles, études, chiffres)

- Recouper et vérifier les données fournies par l’IA

- Adapter le ton et le message au positionnement de l’entreprise

Une IA peut suggérer une tendance virale… mais seul un communicant sait si elle sert réellement la stratégie.

Parole d’expert – Frédéric Foschiani

« J’utilise régulièrement l’IA comme outil d’aide à la veille et à l’idéation éditoriale. Mais une règle ne varie jamais : aucune donnée, aucun chiffre, aucune citation ne doivent être repris sans vérification humaine. L’IA peut proposer des angles ou des tendances, mais elle produit trop souvent des contenus crédibles… mais faux. L’exemple Deloitte illustre parfaitement ce risque. Dans un contexte professionnel, publier une information erronée engagera la responsabilité et la crédibilité de son auteur et de son entreprise. »

Formaliser une charte d’usage interne

Mettre en place une charte IA interne constitue aujourd’hui une bonne pratique, recommandée par l’article 4 de l’AI Act (AI literacy).

Elle doit notamment préciser les :

- outils autorisés

- usages acceptables

- règles de confidentialité applicables à l’utilisation des outils d’IA

- règles de traçabilité et d’étiquetage des contenus générés ou modifiés par une IA

- mentions à afficher lorsqu’un contenu est généré ou modifié par une IA

- nécessité d’une relecture humaine systématique

Certaines entreprises ont déjà formalisé ce cadre, allant jusqu’à intégrer une « procédure de disclosure IA » pour leurs publications, notamment sur les réseaux sociaux.

Ce dispositif interne vise à informer le public ou les utilisateurs lorsqu’un contenu a été généré ou modifié par une intelligence artificielle, afin d’éviter toute confusion avec une production humaine ou une information authentique. Ce type d’initiative témoigne d’une approche mature : la technologie est intégrée aux pratiques, mais jamais utilisée sans contrôle.

Parole d’expert – Frédéric Foschiani

« Cette nécessité de cadrage n’est pas théorique. Elle ressort très concrètement du terrain. Dans mes accompagnements, je constate que l’erreur la plus fréquente n’est pas l’usage de l’IA, mais l’absence de cadre. De plus en plus d’entreprises mettent à disposition des solutions d’IA internes afin de limiter les risques liés à la diffusion de données sensibles ou confidentielles en dehors de l’organisation. En revanche, ces outils sont souvent déployés sans accompagnement réel des équipes sur les bonnes pratiques d’usage. Les salariés disposent de la technologie, mais pas toujours des repères nécessaires pour l’utiliser efficacement et de manière responsable. Cela concerne aussi bien la maîtrise du prompting, savoir formuler une demande claire pour obtenir un résultat exploitable rapidement, que la compréhension des limites de l’IA, de ses biais ou des obligations réglementaires à respecter dans un cadre professionnel, notamment en matière de transparence et de traçabilité des contenus. Sans ce cadre, l’IA devient un outil sous-exploité ou, à l’inverse, un facteur de risque évitable pour la communication et la réputation de l’entreprise. »

Anticiper les erreurs et les crises de communication

L’histoire récente regorge d’exemples où l’IA a trahi la communication qu’elle devait servir. Par exemple, une entreprise avait publié une image d’équipe médicale générée par IA pour illustrer une campagne. Les internautes ont rapidement détecté l’artificialité du visuel : erreurs anatomiques, visages flous, détails incohérents. Résultat : l’entreprise a été accusée de fausse représentation et d’instrumentalisation de l’humain. Même en dehors des réseaux sociaux, ce type d’erreur rappelle à quel point la vigilance est indispensable.

En octobre 2025, Deloitte a été contraint de rembourser l’État australien après avoir remis un rapport truffé d’erreurs générées par l’IA. Fausses références, citations juridiques inexactes et incohérences ont été relevées, attribuées à l’usage non maîtrisé d’outils d’IA générative. Cet exemple illustre un point clé : une erreur générée par l’IA devient toujours une erreur humaine.

Les actions à prévoir :

- se former à une bonne utilisation de l’IA pour comprendre les biais et les risques

- maîtriser le prompting pour être le plus précis possible sur les instructions données à l’IA

- instituer un protocole de validation stricte (relecture, vérification des sources, tests de cohérence)

- établir un plan de réponse de crise, incluant des messages de clarification, des rectifications publiques et la transparence sur l’origine de l’erreur

- tenir et archiver un registre de contenus générés par IA pour assurer une traçabilité

Une erreur d’IA, qu’elle soit interne ou externe, sur un site web ou un post, devient toujours, tôt ou tard, une erreur de communication. Les processus de contrôle et de réaction ne sont pas une option : ils sont le filet de sécurité de toute stratégie IA responsable.

Crédibilité, qualité et SEO : les nouveaux indicateurs de confiance

L’évaluation du contenu par les moteurs de recherche

Google l’a rappelé, ce n’est pas le mode de création qui compte, mais la valeur apportée. Les contenus IA sont évalués comme les autres selon la logique E-E-A-T : expérience, expertise, autorité et fiabilité. Un contenu généré par IA peut donc être bien référencé, à condition d’être vérifié, contextualisé et enrichi par une expertise humaine.

L’enjeu pour les communicants n’est plus d’éviter l’IA, mais de l’encadrer pour qu’elle contribue à produire des contenus à forte valeur ajoutée.

Transparence et réputation

Mentionner que l’IA a contribué à la création d’un contenu ne diminue pas la confiance, au contraire. Cette transparence devient un marqueur de sérieux et d’éthique. Une entreprise qui cache son usage de l’IA prend aujourd’hui plus de risques qu’elle n’en évite. Transparence, vérification et contrôle humain restent les piliers d’une communication responsable augmentée par l’IA.

Le double regard

La relecture humaine reste la meilleure garantie de crédibilité. Elle permet de corriger les approximations, de valider les informations, d’adapter le ton, d’éviter les biais et de garantir la cohérence avec la stratégie globale. Ce double regard, IA pour la productivité et humain pour la fiabilité, définit la nouvelle frontière de la communication responsable.

7 réflexes pour une communication responsable avec l’IA

- Vérifier les sources, chiffres, citations… générés par l’IA avant toute diffusion.

- Mentionner l’usage de l’IA quand elle a participé à la création d’un texte, d’un visuel, d’un audio ou d’une vidéo.

- Appliquer une relecture humaine systématique pour valider le ton, le fond et la cohérence.

- Mettre à jour sa charte interne IA au fil des évolutions légales et technologiques.

- Surveiller les réactions du public pour anticiper les incompréhensions ou les critiques liées à la transparence.

- Ne jamais exposer d’informations confidentielles et de données personnelles dans un outil d’IA non validé par l’organisation.

- Conserver la preuve (registre) de l’utilisation de l’IA.

Formez-vous !

Comprendre les cadres réglementaires, maîtriser les outils d’IA et préserver la crédibilité de sa communication suppose une montée en compétences continue. ORSYS propose plusieurs formations spécifiquement conçues pour accompagner les communicants et les community managers dans ces nouveaux usages.

- Community management : booster son organisation et sa communication avec l’IA

- L’essentiel pour améliorer sa présence sur les réseaux sociaux avec l’IA

- L’IA pour créer des contenus percutants (textes, visuels, vidéos)

Ces formations s’inscrivent dans l’offre globale de l’IA Academy ORSYS et des formations en communication d’entreprise.

L’IA ne remplace pas la communication, elle en révèle les failles et les forces. Utilisée avec méthode, elle devient un outil d’anticipation, de créativité et d’efficacité. Sans cadre, elle expose à la confusion, voire à la perte de confiance. La communication de demain sera hybride : humaine dans son intention, augmentée dans sa forme. Et c’est à la lucidité des professionnels que se jouera la différence entre innovation et imprudence.