Grâce à de nouveaux modèles d’IA générative, les robots ne se contentent plus d’exécuter. Ils perçoivent, interprètent et interagissent avec leur environnement. Un progrès spectaculaire qui laisse augurer des robots polyfonctionnels capables de réaliser des tâches complexes. Le point sur ces avancées et sur les compétences à développer pour s’approprier ces technologies.

Quand l’IA générative transforme la robotique : des démonstrations spectaculaires

C’est le retour du Turc mécanique à l’ère de l’IA.

Début novembre, le constructeur automobile chinois Xpeng dévoilait son robot humanoïde Iron. La fluidité de ses mouvements suscite autant de fascination que de scepticisme sur les réseaux sociaux. Les internautes crient aussitôt à la supercherie, suspectant un humain dissimulé dans la machine, à l’instar du Turc mécanique, le célèbre faux automate joueur d’échecs.

Pour couper court aux rumeurs, Xpeng réagit avec une seconde vidéo. On y voit un assistant découper les couches de tissu qui recouvrent la jambe du robot afin de mettre à nu ses mécanismes internes… sans humain caché.

Ce type de démonstrations saisissantes est appelé à se multiplier avec les progrès de ces derniers mois dans la robotique. Comme dans bien d’autres domaines, on doit ce saut disruptif à l’IA générative.

Mais ici, l’enjeu n’est pas de générer du texte ou des images. Il s’agit plutôt de doter les robots de nouvelles capacités motrices et sensorielles. Cela leur permettant de mieux appréhender leur environnement et de gagner en autonomie et en polyvalence.

©Xpeng

Des robots programmés à la main… à des modèles autonomes

Les limites de la programmation traditionnelle

« Actuellement, la programmation des robots représente une tâche extrêmement complexe, avance Stéphane Doncieux, directeur de l’ISIR (Institut des systèmes intelligents et de la robotique) et professeur d’informatique à Sorbonne Université-CNRS. Chaque comportement qu’un robot doit exécuter doit être explicitement programmé par un ingénieur, qui doit réfléchir à chaque action requise, aux conditions d’exécution, aux réactions appropriées en cas d’événement inattendu. ».

Cette restriction explique pourquoi les robots industriels sont condamnés à réaliser la même tâche à l’infini sur les chaînes des constructeurs automobiles ou des acteurs de l’industrie manufacturière, même s’ils sont en théorie reprogrammables et de plus en plus collaboratifs.

Plus récemment, ces robots se sont dotés d’algorithmes de vision pour détecter et trier les pièces défectueuses sur une chaîne de production. « Ce cas d’usage reste confiné à des contextes hautement maîtrisés, poursuit Stéphane Doncieux. Dans ce type de scénario, nous connaissons précisément le type de pièces en entrée et en sortie. »

Les robots domestiques : un premier pas vers l’autonomie

Dans la sphère domestique, les robots aspirateurs ou tondeuses à gazon évoluent dans un environnement moins maîtrisé que dans les usines. Pour autant, les tâches attendues restent suffisamment simples pour être exprimées par des comportements élémentaires. Rencontrant un obstacle, le robot domestique change de trajectoire et continue sa route.

L’apport de l’IA générative à la robotique

La nouvelle génération de robots dopés à l’IA réalise des manipulations autrement plus sophistiquées. Pour illustrer les apports de l’IA générative, Cédric Vasseur, expert en intelligence artificielle et robotique et formateur chez ORSYS, conseille à ses apprenants de visionner les vidéos de démonstration des robots humanoïdes de Figure AI.

« Elles démontrent concrètement ce qu’on peut aujourd’hui accomplir, que ce soit en reconnaissance visuelle ou textuelle. » Dans l’une de ces vidéos, on voit un robot délicatement ranger des assiettes, des bols et des verres dans un lave-vaisselle.

L’apport des nouveaux modèles VLM et VLA pour les robots

Pour réaliser de telles prouesses, les roboticiens font appel à des dérivés des fameux LLM.

Les VLM (Vision Language Models) permettent au robot de relier images et langage. Tandis que les VLA (Vision Language Action) transforment ces perceptions en mouvements coordonnés.

Résultat : avec ces modèles, un robot peut désormais comprendre une instruction en langage naturel, observer une scène, puis agir.

Bardés de multiples capteurs – de flexion, de température, à ultrasons -, de caméras 3D RVB-D – combinant les données de couleur (RVB) et de profondeur (D) -, ou de lidars, le robot prend l’information de l’extérieur puis adapte son comportement en conséquence.

Les modèles VLA convertissent ensuite ces données visuelles et textuelles en commandes motrices. Pour Stéphane Doncieux, il s’agit d’étendre la promesse des outils d’IA générative à la robotique. « L’objectif est de créer des modèles suffisamment généraux pour appréhender un environnement, recevoir des instructions en langage naturel, et permettre au robot d’exécuter les actions nécessaires pour accomplir la tâche demandée. »

Le robot qui remplit un lave-vaisselle : un exemple emblématique

La vidéo de démonstration ci-dessus de Figure AI montre un robot capable de manipuler assiettes, verres ou couverts avec une précision surprenante.

Ce qui peut sembler trivial pour un humain – remplir un lave-vaisselle – présente, en fait, une grande complexité pour un robot. « Saisir et manipuler un objet fait intervenir non seulement la vision, mais aussi l’ancrage dans le corps du robot, nécessitant une dextérité manuelle suffisante, potentiellement un retour tactile, et bien d’autres facteurs bien plus complexes qu’un jeu de stratégie », poursuit Stéphane Doncieux. La machine peut battre l’homme aux échecs et au jeu de go, mais éprouver les pires difficultés à saisir et ouvrir une gourde.

C’est le fameux paradoxe de Moravec qui se résume à l’idée que « le plus difficile en robotique est souvent ce qui est le plus facile pour l’homme ».

©Tesla

Vers des modèles fondamentaux… pour les robots

L’époque où chaque robot devait apprendre seul touche à sa fin. De nouveaux modèles dits « fondamentaux » émergent, capables d’ingérer l’expérience de multiples machines.

Des VLA génériques comme RT-2 — bientôt supplanté par des versions plus larges — ou Isaac GR00T de Nvidia, ou encore Helix de Figure AI, étendent les capacités en s’appuyant sur des données venues d’une multitude d’environnements.

Les modèles ouverts comme OpenVLA complètent cet écosystème, permettant une adaptation à divers bras, plateformes mobiles ou prototypes humanoïdes.

L’idée est simple : au lieu d’entraîner un robot, on entraîne la compétence elle-même, puis on la distribue d’un robot à l’autre.

Données, simulation et « world models » : les nouveaux carburants de cette révolution

Un déficit de données robotiques

Entraîner les modèles à l’extrême variabilité du monde réel suppose, par ailleurs, un volume considérable de données. Développés par Boston Dynamics, Google, Xpeng ou Nvidia, les modèles VLA comprennent des milliards de paramètres qu’il faut pouvoir alimenter.

Or, si les modèles « traditionnels » d’IA générative ont largement accès aux corpus de textes et aux banques d’images, les données robotiques sont, elles, beaucoup plus limitées.

Pour pallier ce déficit, les roboticiens construisent de grands jeux de données multirobots, par exemple issus de collaborations entre laboratoires et industriels. Autre solution : utiliser massivement la génération de données synthétiques, via des simulateurs physiques et des « world models » capables de créer des environnements virtuels quasi infinis, comme Genie 3 de Google DeepMind ou les outils de simulation de Nvidia.

L’idée est d’exposer les modèles à une diversité de situations impossible à reproduire uniquement avec des robots physiques dans des labos.

De nombreux défis à relever dans le monde réel

D’autres défis doivent être relevés, dans le monde réel cette fois. Le contrôle du mouvement robotique est un art délicat.

S’il est simple d’indiquer au robot de positionner son bras au niveau du bouchon d’une gourde. Lui demander ensuite de tourner avec sa pince ledit bouchon suppose d’exercer une certaine pression selon le bon angle. « Des gestes du quotidien font appel à des modes de contrôle qui n’impliquent pas uniquement la position, rendant le contrôle du mouvement plus compliqué qu’il n’y paraît », fait observer Stéphane Doncieux.

De son côté, Cédric Vasseur met en garde contre l’illusion donnée par certaines vidéos de démonstration : elles sont tournées en studio avec un éclairage optimal, sans éléments perturbateurs susceptibles de gêner le robot ou son système de vision. « Les objets manipulés ont des couleurs très contrastées afin de faciliter leur identification par l’IA ». Le robot a aussi pu être entraîné à un environnement donné. Pour reprendre l’exemple du lave-vaisselle, un robot a appris des heures durant à le vider dans une cuisine spécifique. Mais si vous le déplacez dans une autre cuisine, tout est à refaire.

Des enjeux de sécurité, d’éthique… et de réglementation

Sécurité physique et cybersécurité

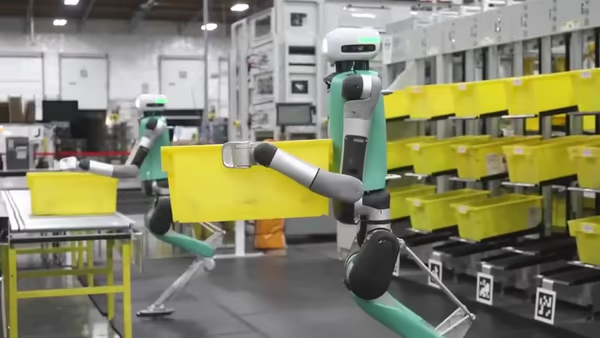

Avant l’adoption dans nos foyers de robots domestiques, l’industrie sera le premier domaine d’implémentation, selon Cédric Vasseur.

« De nombreux projets sont déjà en cours en Europe, en particulier en Allemagne, où de grands groupes industriels travaillent sur l’utilisation de robots humanoïdes. Par ailleurs, des acteurs de l’e-commerce, à l’image d’Amazon ou d’Alibaba, investissent massivement dans la création d’entrepôts entièrement automatisés, à base d’automates, de tapis roulants ou de convoyeurs automatisés ».

©Agility Robotics

La mise en production de ce type de robot avancé soulève un certain nombre de risques. Sécuritaires tout d’abord. Devenant communicante, la machine augmente sa surface d’attaque. « Si un robot répond à n’importe quelle commande vocale, il pourrait nuire à autrui et réaliser des actes potentiellement malveillants ou illégaux », alerte Stéphane Doncieux. À ces risques cyber s’ajoutent des risques physiques imprévisibles. Le robot est confronté à tous aléas du monde réel ou faire l’objet d’un acte de sabotage.

Éthique : responsabilité et compétences humaines

Nos deux experts soulèvent également des enjeux éthiques et sociaux qu’entraînerait une généralisation de robots dopés à l’IA. Stéphane Doncieux évoque une perte de responsabilité – face à des outils qui semblent être pertinents la plupart du temps, leurs utilisateurs peuvent être incités à les laisser décider en autonomie, sans endosser la responsabilité des décisions prises – et, par contrecoup, une perte de compétences.

Il faudra également composer avec les attentes des salariés sur les conditions d’introduction de ces robots sur leur lieu de travail.

Réglementation : l’AI Act

La réglementation est aussi à prendre en compte, avec les cadres réglementaires émergents, qu’il s’agisse de la sécurité des machines ou des réglementations spécialisées sur l’IA. En Europe, avec l’AI Act, les robots dotés d’IA avancées deviennent des systèmes à haut risque. Ce statut impose une discipline stricte : audits, documentation complète, transparence des modèles, suivi continu, cybersécurité renforcée.

Ce n’est pas une contrainte artificielle : plus les robots apprennent, plus ils doivent prouver qu’ils restent fiables, prévisibles et sécurisés.

Quelles formations pour la robotique avancée ?

L’ingénieur roboticien de 2025 n’a plus le même visage que celui de 2015. Il connaît ROS 2 comme sa poche, comprend la vision industrielle avancée, manipule les simulateurs comme Isaac Lab avec la même aisance qu’un superviseur manipule son pressostat. Il sait aussi entraîner un modèle d’imitation, interpréter les sorties d’un système de vision, diagnostiquer un échec d’apprentissage.

La programmation reste indispensable, mais elle n’est plus centrale : ce qui compte désormais, c’est la capacité à orchestrer des pipelines complexes où perception, IA et mécanique doivent dialoguer parfaitement.

« Pour travailler sur ce type de projets, il est important d’être polyvalent et de développer un grand nombre de compétences mêlant robotique et intelligence artificielle », soutient Cédric Vasseur.

Les formations ORSYS

ORSYS propose pour cela des séminaires État de l’art. Destinés aux décisionnaires et aux chefs de projet, ils permettent de faire un point sur les dernières avancées dans le domaine.

C’est le cas de la formation « Robotique, état de l’art » (ROB), qui passe en revue les applications passées, actuelles et futures de la robotique et des apports de l’IA.

Pour les décideurs et chefs de projet, un autre séminaire présente les solutions d’IA générative du marché et leurs usages (IAP). Il existe également une formation plus spécifique sur l’IA et la robotique au service de la santé (IAZ).

Pour des profils plus techniques, on trouve ensuite des ateliers qui vont se concentrer sur une technologie comme ROS (Robot Operating System) qui permet de créer des applications robotiques (ROH), ou encore la formation atelier « Intelligence artificielle, algorithmes utiles appliqués à la robotique » (IAG). Ces parcours permettent de comprendre concrètement comment exploiter les nouveaux modèles VLM/VLA, la simulation et les outils open source dans des projets réels.

« La maîtrise de la programmation reste incontournable, poursuit Cédric Vasseur. Quelle que soit la nature du robot développé, il faudra un moment ou l’autre le programmer. » Des connaissances en conception 3D sont également essentielles, tant pour le design que pour appréhender les contraintes physiques auxquelles sera soumis le robot.

Par ailleurs, la gestion de projet représente une compétence clé. « Un projet de robotique est complexe, complète le formateur. Il implique différents corps de métiers et la coordination de nombreux composants et périphériques. » En ce qui concerne la partie purement robotique, il est essentiel de maîtriser à la fois des compétences mécaniques et électroniques. « Certaines opérations se font à la main quand il s’agit de faire des soudures ou de concevoir son propre circuit électronique. »

La sécurité : celle des robots mais aussi celle des IA

Pour le volet sécurité, Cédric Vasseur anime un module de formation d’une journée axé sur l’intelligence artificielle et la sécurité opérationnelle (ICY). Les participants découvrent comment se protéger face aux nouvelles menaces liées à l’IA, aussi bien dans le monde virtuel que physique. Enfin, l’expert a coécrit un livre blanc, publié par ORSYS, sur l’IA et la cybersécurité afin d’approfondir cette thématique. Dans un contexte où robots et IA générative convergent, cette compétence sécurité devient centrale, dès la conception des systèmes.

Les robots dopés à l’IA générative ne se contentent plus d’exécuter, ils décident et s’adaptent. À nous, dès maintenant, d’en comprendre les limites, d’en sécuriser les usages et de nous former pour garder la main sur cette nouvelle puissance industrielle.

©UBTech